- Blog , Artificial Intelligence

- Veröffentlicht am: 21.11.2024

- 13:15 mins

Prozessoptimierung durch KI: Maximale Produktivität mit Künstlicher Intelligenz

Künstliche Intelligenz – eine Technologie, die wie kaum eine andere weltweit zahlreiche Branchen transformiert und einen enormen Druck auf die Industrie ausübt. Tausende Unternehmen stehen vor der Herausforderung, die rasant voranschreitende Entwicklung von KI und die daraus hervorgehenden Innovationen schnell und effizient in wertschöpfende Anwendungen zu integrieren.

Doch der Aufwand lohnt sich: Mithilfe von KI-Services können Sie beispielsweise Workflows automatisieren, Manufacturing Prozesse optimieren und somit Ihre gesamte Prozesseffizienz steigern sowie Ihre Kosten reduzieren. Ein hoher Automatisierungsgrad ist dabei eine entscheidende Voraussetzung für die erfolgreiche Einbindung von KI-Services.

Die Zielsetzung liegt auf der Hand: Unternehmen müssen sichere, wertschöpfende und nachhaltige KI-Services implementieren, um mit der Konkurrenz Schritt zu halten. Dies erfordert eine abgestimmte KI-Service-Infrastruktur, auch bei der Implementierung bereits fertiger Modelle oder APIs. Ohne eine passende Infrastruktur sowie einen dazugehörigen Entwicklungsansatz schlägt der Einsatz der KI-Technologie fehl.

Dieser Blogbeitrag beleuchtet, wie MHP Ihrem Unternehmen helfen kann, die Herausforderungen der KI-Skalierung zu meistern und die Chancen optimal zu nutzen.

KI im Unternehmen: Herausforderungen bei der Skalierung von KI-Services

Die Integration und Skalierung von Künstlicher Intelligenz in Unternehmen bietet enorme Chancen, stellt jedoch gleichzeitig eine erhebliche Herausforderung dar. Viele Unternehmen kämpfen damit, ihre KI-Services effizient und erfolgreich zu skalieren, um den maximalen Nutzen aus diesen Technologien zu ziehen. Die oftmals mangelnde oder fehlerhafte Skalierung ist meist darauf zurückzuführen, dass einzelne oder mehrere Teilprobleme nicht oder falsch adressiert werden. Auf die signifikantesten Pain Points gehen wir im Folgenden noch etwas detaillierter ein:

Schlechte Datenqualität

Eine der größten Herausforderungen besteht in der Sicherstellung hochwertiger und konsistenter Daten. AI-Modelle sind nur so gut wie die Daten, mit denen sie trainiert werden. Die Qualität der Daten spielt demnach eine entscheidende Rolle. Zusätzlich muss darauf geachtet werden, die große Menge an benötigten Daten sinnvoll zu strukturieren und für die weitere Verarbeitung abzulegen, um die Entwicklung von AI-Services nicht aufgrund mangelhafter Datenverfügbarkeit auszubremsen. Unternehmen sollten daher in robuste Datenmanagementstrategien investieren und qualitativ hochwertige Daten bereitstellen, um eine gute Datenqualität, -konsistenz und -verfügbarkeit sicherzustellen.

Fehlerhaftes Systemdesign

Ein häufiges Hindernis bei der Implementierung von AI-Services ist ein unzureichendes oder fehlerhaftes Systemdesign. Um AI-Services erfolgreich zu integrieren, muss das Systemdesign nicht nur den spezifischen Anforderungen des AI-Modells entsprechen, sondern auch auf die Art des zu lösenden Problems abgestimmt sein. Das bedeutet, dass das System sowohl den passenden Algorithmus als auch die notwendigen Ressourcen berücksichtigt, um die Herausforderung effizient zu adressieren. Ein robustes und skalierbares Systemdesign muss flexibel genug sein, um auf Veränderungen im Datenfluss und den Anforderungen des Modells zu reagieren, während es gleichzeitig sicherstellt, dass die Integration reibungslos und nachhaltig verläuft. Nur so können AI-Services effektiv betrieben und langfristig optimiert werden.

Dynamische AI-Modelle

In einem produktiven System mit sich ständig wechselnden Umgebungsbedingungen verändern sich auch permanent die zu verarbeitenden Daten, was eine dynamische Anpassung der AI-Modelle erfordert. Somit muss sichergestellt werden, dass über den kompletten Lifecycle eines AI-Service automatisierte Anpassungen vorgenommen werden, die selbstverständlich entsprechenden Qualitätsüberprüfungen unterzogen werden müssen. So garantieren Sie einen effizienten Einsatz und eine hohe Qualität über einen langen Zeitraum hinweg.

Hohe Entwicklungsgeschwindigkeit von AI-Services

Nicht nur die Umgebungsbedingen und Daten verändern sich, sondern auch die AI-Services selbst. Die Innovationssprünge sind im Bereich der Künstlichen Intelligenz nach wie vor enorm, sodass Unternehmen sicherstellen müssen, dass sie mit der rasanten Entwicklungsgeschwindigkeit von AI-Applikationen Schritt halten können, um stets von den aktuellsten Technologien zu profitieren. Andernfalls fällt Ihr Unternehmen sehr schnell hinter dem Wettbewerb zurück und nimmt eine deutlich schwächere Marktposition ein.

Unterschiedliche Herausforderungen und Aufgaben bei AI und GenAI

Klassische AI: Erfordert umfangreiche Ressourcen für das Training der Modelle. Der Schwerpunkt liegt auf der Entwicklung und dem Training von Modellen sowie deren kontinuierlicher Optimierung und Versionierung.

Generative AI (GenAI): Hier entfällt das Training weitgehend, da oft vortrainierte Modelle genutzt werden. Der Fokus verschiebt sich auf die Optimierung der Prozesse, die das Modell umgeben. Dabei ist jedoch eine sorgfältige Auswahl des passenden Modells entscheidend, damit es zur spezifischen Problemstellung passt – sei es für die Textverarbeitung, die Bildanalyse oder Zeitreihen. Neben der funktionalen Eignung des Modells spielt auch die Kostenbetrachtung eine zentrale Rolle. Unternehmen müssen die Betriebskosten der Modelle, wie etwa Rechenleistung und Speicherbedarf, im Blick behalten, um die Effizienz und Wirtschaftlichkeit der GenAI-Lösungen sicherzustellen.

MHP’s Lösungsansatz für eine effektive Skalierung von AI-Services

Die effektive Skalierung von AI-Services erfordert einen strategischen Ansatz, der Technologie, Menschen und Prozesse optimal miteinander verknüpft. MHP bietet hierfür umfassende Lösungen, die auf langjähriger Erfahrung und einer klaren Fokussierung auf Skalierbarkeit und Effizienz basieren.

AI Engineering als ganzheitlicher Ansatz für die optimale Skalierung

AI Engineering spielt eine zentrale Rolle bei der Entwicklung, Implementierung und Wartung von KI-Systemen. Durch die Kombination von Software-Engineering, Datenwissenschaft, Systemarchitektur und MLOps wird das Ziel verfolgt, skalierbare, zuverlässige und effiziente KI-Lösungen zu erstellen.

Die Kernaspekte von MLOps sind:

Automatisierung: MLOps automatisiert den gesamten Lebenszyklus von Machine-Learning-Modellen, von der Datenerfassung und -aufbereitung über das Training und die Validierung bis hin zur Bereitstellung und Überwachung der ML-Modelle. Die kontinuierliche Integration und Bereitstellung (Continuous Integration/Continuous Deployment, CI/CD) der Modelle gewährleistet so eine nahtlose und effiziente Entwicklung.

Zusammenarbeit: Crossfunktionale Teams ermöglichen eine interdisziplinäre Zusammenarbeit zwischen Data Scientists, Data Engineers, DevOps und anderen Stakeholdern. Auf diese Weise wird sichergestellt, dass alle Beteiligten auf dem gleichen Stand sind und effizient zusammenarbeiten können, um die Qualität und Geschwindigkeit der Modellentwicklung zu erhöhen.

Skalierbarkeit: MLOps stellt sicher, dass ML-Systeme in der Lage sind, große Datenmengen und hohe Anfragenvolumen zu bewältigen. Dies ist für die Skalierung und die Bereitstellung robuster und leistungsfähiger Modelle in Produktionsumgebungen entscheidend.

Sicherheit und Compliance: Die Implementierung von Sicherheitsmaßnahmen und die Einhaltung gesetzlicher Vorschriften sind integraler Bestandteil von MLOps. Darunter fällt der Schutz sensibler Daten, die Sicherstellung der Datenintegrität und die Einhaltung von Datenschutzbestimmungen, um den sicheren und rechtskonformen Betrieb der Modelle zu gewährleisten.

Überwachung und Verwaltung: Die kontinuierliche Überwachung und Versionierung von Modellen ist wichtig, um deren Leistung und Funktionsfähigkeit sicherzustellen. Dies beinhaltet die Überwachung von Modellmetriken, das Management von Modellversionen und die Implementierung von Mechanismen zur Fehlererkennung und -behebung.

Betrieb der Systeme: Zudem umfasst MLOps den Betrieb und die Wartung von ML-Modellen und -Plattformen. Dazu zählen die Verwaltung von Ressourcen, die Optimierung der Systemleistung und die Sicherstellung der Verfügbarkeit und Zuverlässigkeit der ML-Services während ihrer Anwendung.

Die wichtigsten Ziele des AI Engineerings sind:

- Erstellung skalierbarer und effizienter KI-Lösungen: Durch die Kombination verschiedener Disziplinen wird sichergestellt, dass KI-Anwendungen robust und leistungsfähig sind.

- Effektives Management von KI-Modellen: Von der Konzeption über die Entwicklung bis hin zur Produktion wird der gesamte Lebenszyklus der Modelle abgedeckt.

- Kontinuierliche Verbesserung und Betrieb von KI-Anwendungen: Regelmäßige Updates, Monitoring und Optimierungen gewährleisten, dass die Modelle stets auf dem neuesten Stand sind und funktionsfähig bleiben.

AI Engineering zieht sich über den Entwicklungszyklus hinweg durch verschiedene, aufeinander aufbauende Entwicklungsschritte in unterschiedlichen Einsatzumgebungen. In der Proof-of-Concept-Phase wird zunächst in einer lokal begrenzten Umgebung mithilfe von Testdaten die grundlegende Funktion des Modells getestet. Anschließend wird in einer Pilotphase ein MVP (Minimum Valuable Product) mit immer höherem Reifegrad in verschiedenen Entwicklungs-, Test- und realen Einsatzumgebungen ausgiebig getestet. Läuft dieser Test nach Plan, folgt die Releasephase in der produktiven Umgebung mit vollem Funktionsumfang und nahtloser Integration ins Produktivsystem.

Der Ansatz auf Basis von AI Engineering ist dabei losgelöst vom AI-Modell und somit frei in eine standardisierte Lösungslandschaft integrierbar. Für einen optimalen Kundennutzen sind individuelle und kundenspezifische Ansätze trotzdem erlaubt.

Crossfunktionaler Teamansatz (ONE Team)

MHP setzt auf einen crossfunktionalen Teamansatz, der als ONE Team bezeichnet wird.

Dieses Team besteht aus:

- AI Product Manager: Integration der Datenanforderungen, Priorisierung von Produktmerkmalen und Schnittstelle zwischen Kunde und Entwicklungsteam

- Data Scientist: Durchführung von Experimenten, Entwicklung und Auswahl der Modelle

- Data (Infrastructure) Engineer: Aufbau der Dateninfrastruktur

- AI Engineer: Überführung, Skalierung, Integration, Überwachung und Fehlerbehebung des ML-Modells

- Software/Frontend Engineer: je nach AI Use Case, Verarbeitung der Schnittstelle in einem Frontend, einem Dashboard oder in einer Applikation

Die Vorteile des ONE Teams von MHP sind vielfältig und tragen wesentlich zur erfolgreichen Skalierung von AI-Services bei. Durch die interdisziplinäre Zusammenarbeit, die verschiedene Expertisen innerhalb eines Teams kombiniert, entstehen innovative und effektive Lösungen. Die Dezentralisierung der Expertise bedeutet, dass Expert:innen für verschiedene Bereiche in der gesamten Organisation verteilt sind und spezifische AI-Produkte verantworten. Gleichzeitig gibt es eine Zentralisierung der Produktteams, wobei ein zentrales Team, das Centre of Excellence, alle Fähigkeiten und Rollen vereint, um AI-Produkte für die gesamte Organisation zu entwickeln. Dabei besitzt jede unserer Rollen spezifisches Fachwissen zu ihrem Expertengebiet sowie ein breites Kompetenzprofil. Auf diese Weise behalten wir alle relevanten Schnittstellen im Blick und können diese effektiv bedienen.

Ganzheitlicher Ansatz für eine optimale Skalierung durch AIDevOps@MHP mit CRISP-AI Framework

Als Basis für eine schnelle und zielgerichtete Umsetzung setzen wir von MHP auf unser selbst entwickeltes Framework AIDevOps@MHP.

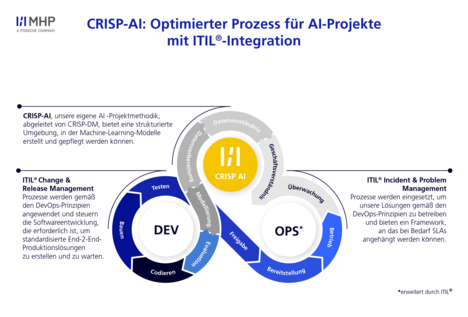

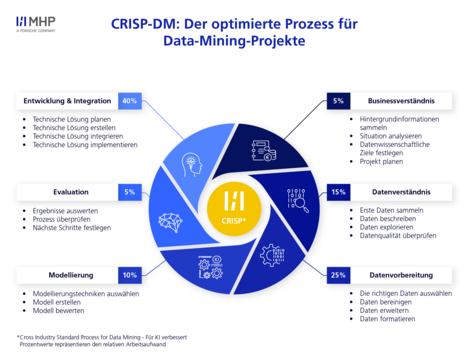

AIDevOps@MHP baut auf CRISP-AI auf, was wiederum aus CRISP-DM (Cross Industry Standard Process for Data Mining) abgeleitet und durch Deploy-and-Run-Aspekte erweitert wurde. Bei CRISP-DM handelt es sich um einen einheitlichen Standard für Data-Mining-Prozesse, der über sechs Phasen hinweg Aktivitäten zum Verständnis des aktuellen Zustands über die Datenvorbereitung und -modellierung bis hin zur Bewertung und Integration beschreibt.

Das Framework AIDevOps@MHP geht noch einige Schritte weiter als klassisches MLOps und kombiniert die CRISP-AI-Ansätze mit DevOps-Prinzipien und ITIL-Prozessen (IT Infrastructure Library).

Die Anwendung von DevOps-Prinzipien ermöglicht eine schnelle Bereitstellung von Produkten und reduziert die Architekturkomplexität. Zudem fördert sie eine verbesserte Arbeitskultur innerhalb der Teams. Diese Prinzipien eignen sich besonders für explorative Projekte im Bereich Data Science, da sie Flexibilität und Effizienz in der Entwicklung und Implementierung von Lösungen bieten. Darüber hinaus hilft die Integration von ITIL-Prozessen, dass die notwendigen Phasen zur Entwicklung eines Produkts oder Service ordnungsgemäß durchlaufen werden.

Durch die intelligente Integration dieser drei Welten liegen die Vorteile gegenüber einem reinen MLOps-Ansatz auf der Hand:

- Integration von Softwareentwicklung und AI: AIDevOps@MHP vereint DevOps-Prinzipien mit den Anforderungen von AI und ML, erweitert die Automatisierung und das Management von ML-Modellen um die Entwicklung AI-basierter Anwendungen und fördert die Zusammenarbeit zwischen Data Scientists, Entwickler:innen und IT-Teams.

- End-to-End-Lösungsansatz: Im Gegensatz zu MLOps, das sich auf Modellbereitstellung und -wartung konzentriert, deckt AIDevOps@MHP den gesamten Lebenszyklus einer AI-Lösung ab, von der Entwicklung bis zur Optimierung, und passt sich dynamisch an Geschäftsanforderungen an.

- Skalierbarkeit und Flexibilität: AIDevOps@MHP bietet eine auf AI-gestützte Anwendungen optimierte Infrastruktur, die durch die Kombination von DevOps und ML eine flexible und effiziente Skalierung ermöglicht, was die Anpassungsfähigkeit der AI-Services erhöht.

- Automatisierung und Continuous Delivery: AIDevOps@MHP geht über die Modellautomatisierung in MLOps hinaus und betont die kontinuierliche Integration und Bereitstellung (CI/CD) von AI-Anwendungen, was schnellere Markteinführungen und Flexibilität ermöglicht.

- Verbesserte Governance und Compliance: Im Vergleich zu MLOps bietet AIDevOps@MHP erweiterte Governance- und Compliance-Funktionen, die sicherstellen, dass AI-Anwendungen den gesetzlichen und ethischen Standards entsprechen und Änderungen umfassend dokumentiert sind.

Der Einsatz von AIDevOps@MHP ermöglicht Ihnen ein kontinuierliches Monitoring, Incident Management und eine Fehlerbehebung in allen Prozessschritten. Das hilft Ihnen, Ihre Code-, AI-Modell- und Datenqualität kontinuierlich hochzuhalten und regelmäßig zu überprüfen. Außerdem hat Ihr Unternehmen die Möglichkeit, neben rein wirtschaftlichen und rationalen Aspekten auch ethische Überlegungen in den gesamten Lebenszyklus von AI-Anwendungen einfließen zu lassen. Dies umfasst die Einbeziehung von Transparenz, Fairness, Verantwortlichkeit, Datenschutz, Sicherheit und Zuverlässigkeit. Durch die Automatisierung von Prozessen in Kombination mit ethischer Compliance wird sichergestellt, dass ethische Standards überprüft und eingehalten werden.

KI Prozessoptimierung: Effektive Skalierung von KI-Services mit MHP

Die Skalierung von KI-Services bringt für Ihr Unternehmen eine Vielzahl von Herausforderungen mit sich, die Sie jedoch mit einem gezielten und umfassenden Ansatz bewältigen können. Sei es eine schlechte Datenqualität, ein fehlerhaftes Systemdesign, sich ändernde Rahmenbedingungen und Daten oder die schnelllebigen Innovationen im Bereich KI – durch den Einsatz von AIDevOps@MHP können Sie in Ihrem Unternehmen die Komplexität der KI-Entwicklung meistern und nachhaltige, wertschöpfende Lösungen schaffen.

Durch die umfassende Kompatibilität zu bestehenden Systemen und die Möglichkeit, individuelle und kundenspezifische Anpassungen vorzunehmen, ist AIDevOps@MHP der richtige Ansatz, um Ihre Produktivität und Effizienz durch automatisierte Prozesse und minimalen Wartungsaufwand zu steigern. Ein hoher Automatisierungsgrad ermöglicht es, KI-Services zuverlässig und effizient zu betreiben, wodurch Ihr Unternehmen Wettbewerbsvorteile hinsichtlich seiner Marktposition und Kundenbindung erzielen kann.

Mit unserer langjährigen Expertise unterstützen und begleiten wir Sie bei der Implementierung und Umsetzung von KI-Services. Mit einem crossfunktionalen Teamansatz und maßgeschneiderten Lösungen hilft MHP Ihrem Unternehmen, die Herausforderungen der KI-Skalierung zu meistern und die Chancen optimal zu nutzen. Wo genau liegen Ihre Probleme und wie können wir Ihnen behilflich sein, diese zu lösen? Kontaktieren Sie uns und lassen Sie sich von unseren Expert:innen persönlich beraten, um für Ihr Unternehmen eine geeignete Lösung zu finden.

FAQ

Eine KI-gestützte Prozessoptimierung verbessert die Effizienz Ihres Unternehmens erheblich, indem sie Routineaufgaben automatisiert und menschliche Fehler reduziert. Durch den Einsatz von KI können große Datenmengen schnell und präzise analysiert werden, was zu besseren und fundierteren Entscheidungen führt. Der hohe Automatisierungsgrad der KI-Services ermöglicht eine kontinuierliche und zuverlässige Betriebsführung mit minimalem Wartungsaufwand. Darüber hinaus kann eine gut implementierte KI-Service-Infrastruktur dazu beitragen, Geschäftsprozesse zu optimieren und die Wettbewerbsfähigkeit Ihres Unternehmens zu steigern.

Unternehmen müssen robuste Datenmanagementstrategien implementieren. Dies beinhaltet eine kontinuierliche Überwachung und Bereinigung der Daten, um Fehler und Inkonsistenzen frühzeitig zu erkennen und zu beheben. Ein solides, flexibles und skalierbares Systemdesign stellt sicher, dass die spezifischen Anforderungen der KI erfüllt werden. Automatisierung spielt ebenfalls eine wichtige Rolle, da sie Prozesse effizienter gestaltet und menschliche Fehler minimiert. Zudem sollten Unternehmen sicherstellen, dass ihre Daten zugänglich, interoperabel und datenschutzkonform sind, um eine nachhaltige Nutzung und Integration der KI-Services zu gewährleisten.

AIDevOps@MHP unterscheidet sich von herkömmlichen DevOps-Praktiken durch seine spezielle Ausrichtung auf AI-Services. Während traditionelle DevOps-Praktiken auf die schnelle Bereitstellung und Integration von Software abzielen, kombiniert AIDevOps@MHP die Prinzipien von CRISP-DM, DevOps und ITIL, um eine nahtlose Entwicklung und Implementierung von AI-Lösungen zu gewährleisten. Dieses Framework legt besonderen Wert auf die Automatisierung und Optimierung des gesamten AI-Lebenszyklus, von der Datenerfassung bis zur Bereitstellung und kontinuierlichen Überwachung der Modelle. Außerdem integriert es ethische Überlegungen wie Transparenz, Fairness und Datenschutz in den gesamten Prozess. Durch diese ganzheitliche und interdisziplinäre Herangehensweise bietet AIDevOps@MHP maßgeschneiderte und nachhaltige AI-Lösungen, die speziell auf die Herausforderungen und Anforderungen moderner Unternehmen zugeschnitten sind.

Um sicherzustellen, dass KI-Lösungen nahtlos in bestehende IT-Systeme integriert werden, ist eine klare Definition der Softwarearchitektur entscheidend. Diese muss den spezifischen Anforderungen der KI-Technologie entsprechen und gleichzeitig flexibel und skalierbar bleiben. Ein hohes Maß an Automatisierung spielt eine wesentliche Rolle, um die Prozesse effizient zu gestalten und mögliche Fehler frühzeitig zu erkennen und zu beheben. Zudem müssen KI-Lösungen interoperabel und datenschutzkonform sein, um eine reibungslose Integration zu gewährleisten. Durch den Einsatz eines crossfunktionalen Teams, das verschiedene Expertisen kombiniert, kann MHP maßgeschneiderte Lösungen entwickeln, die auf Ihre individuellen Bedürfnisse und Herausforderungen abgestimmt sind.

MHP unterstützt Unternehmen bei der Implementierung und Skalierung von AI-Services durch einen ganzheitlichen Ansatz, der Technologie, Menschen und Prozesse optimal verknüpft. Agile Teams aus Software-Ingenieur:innen, Data Scientists und AI-Produktmanager:innen arbeiten zielgerichtet an maßgeschneiderten Lösungen. Durch die Integration von Machine Learning, Computer Vision und Natural Language Processing (NLP) schafft MHP einen signifikanten Mehrwert. MLOps und AI Engineering sorgen für die Automatisierung und Optimierung des gesamten AI-Lebenszyklus, wodurch effiziente und skalierbare AI-Lösungen entstehen. Dieser umfassende Ansatz stellt sicher, dass AI-Services nicht nur technisch einwandfrei, sondern auch geschäftlich wertvoll sind.

Der größte Unterschied zwischen AI- und GenAI-Projekten liegt in ihrem Ansatz und Fokus. Klassische AI erfordert umfangreiche Ressourcen für das Training der Modelle, mit einem Schwerpunkt auf der Entwicklung, dem Training und der kontinuierlichen Prozessoptimierung. Im Gegensatz dazu entfällt bei GenAI weitgehend das Training, da oft fertige Modelle genutzt werden. Der Fokus bei GenAI verschiebt sich auf die Optimierung der umgebenden Prozesse, was eine schlankere Implementierung ermöglicht, jedoch eine sorgfältige Anpassung erfordert. Bei GenAI-Projekten liegt der Schwerpunkt stärker auf AI Engineering und weniger auf Data Science, da mehr Ressourcen für den Datenaufbereitungsprozess benötigt werden.